使用meloTTS 本文生成的音频

使用openVoice clone 自己的声音 阅读本文内容

文件直接上传在github中, 暂未走cdn, 缓存比较慢,可下载播放, 下载地址: http://github.com/weedge/paper-speaker/tree/main/multimoding/voices/open_voice_inference

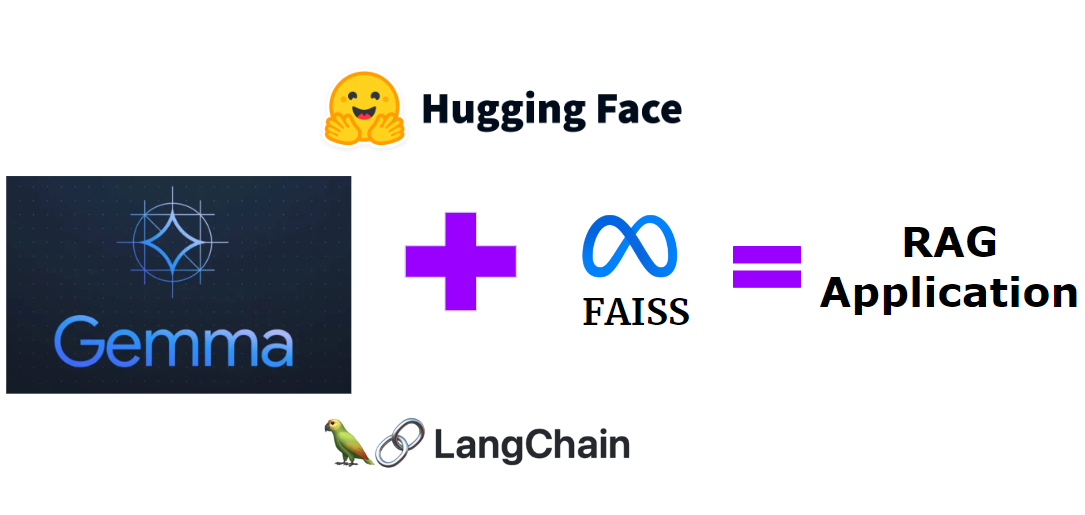

openVoiceV2 tone color clone: base TTS + extra tone color + convert

Base TTS: use meloTTS , 支持TTS模型训练,以及load Pre-Trained ckpt 进行TTS, 在 VITS基础上支持多种语言;

论文地址:OpenVoice: Versatile Instant Voice Cloning

论文主作者:Zengyi Qin (同时是JetMoE的作者,站在巨人的肩膀上创新)

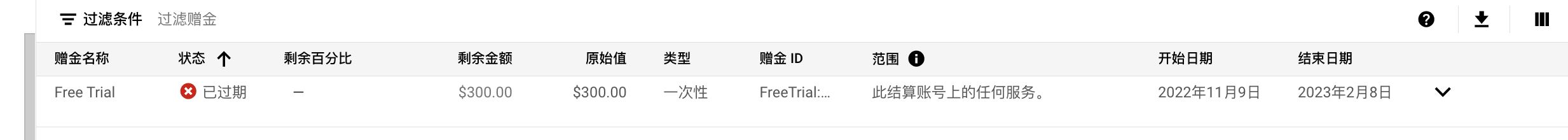

公开的权重:

- OpenVoice: https://huggingface.co/myshell-ai/OpenVoice

- OpenVoiceV2: https://huggingface.co/myshell-ai/OpenVoiceV2

源码:

训练: MSML dataset 和 训练过程 未公开

附操作笔记: https://github.com/weedge/doraemon-nb/blob/main/myshell_ai_OpenVoiceV2.ipynb